Monitor Software

Intel Labs refuerza su apuesta por la visión artificial

Publicación:29-03-2023

TEMA: #Tecnologia

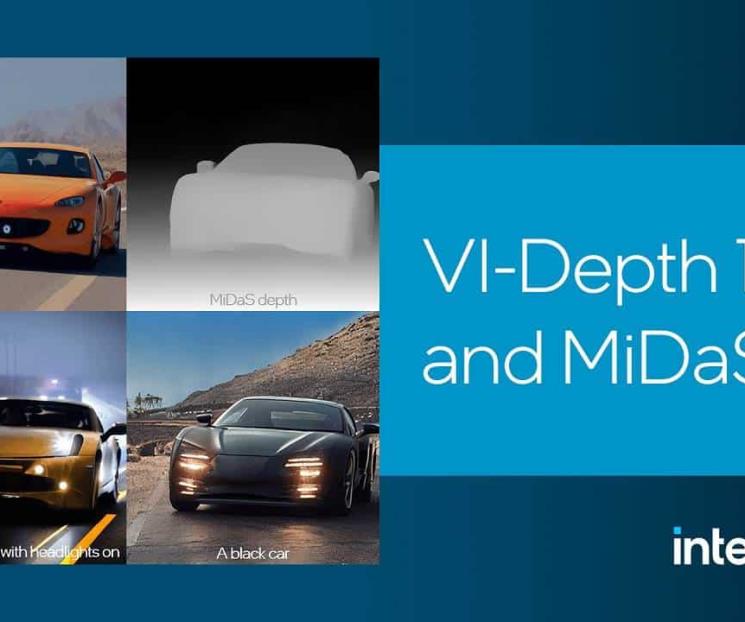

VI-Depth 1.0 y MiDaS 3.1 son dos nuevos modelos para la estimación de la profundidad en la VA, y con ellos Intel Labs ha conseguido un importante avance.

En este artículo vamos a profundizar en ambos y os vamos a contar todas sus claves.

Empezamos con VI-Depth 1.0, que podemos definir como una línea de estimación de profundidad visual-inercial que integra la estimación de profundidad monocular y la odometría visual inercial (VIO) para producir estimaciones de profundidad densa con una escala métrica concreta.

Este método realiza una alineación global de escala y desplazamiento con la profundidad métrica dispersa, seguida de una alineación densa basada en el aprendizaje. La percepción de la profundidad es fundamental para la navegación visual, y estimar correctamente las distancias puede ayudar a planificar el movimiento, a evitar obstáculos y a prevenir accidentes.

La estimación precisa de la profundidad que ofrece VI-Depth 1.0 puede ayudar en la reconstrucción de escenas, en el mapeado y también la manipulación de objetos. Combinar la precisión métrica y la alta generalidad es un desafío fundamental que debemos superar de cara a conseguir una estimación efectiva de la profundidad basada en el aprendizaje.

Esta solución de Intel Labs incorpora los datos inerciales al proceso de estimación visual de la profundidad, no mediante la terminación de la profundidad de dispersa a densa, sino a través de la alineación de la profundidad de densa a densa utilizando factores de escala estimados y aprendidos.

VI-Depth reduce los errores con la alineación local basada en el aprendizaje que con la alineación global por mínimos cuadrados únicamente, y realiza con éxito una transferencia de conjuntos de datos cruzados de disparo cero desde datos de entrenamiento sintéticos a datos de prueba del mundo real.

Este enfoque modular permite la integración directa de los sistemas monoculares de estimación de la profundidad y VIO existentes y futuros. También resuelve la escala métrica para estimaciones de profundidad monocular métricamente ambiguas, ayudando a la implantación de modelos de estimación de profundidad monocular sólidos y generales. VI-Depth está disponible bajo una licencia MIT de código abierto en GitHub.

MiDaS 3.1 de Intel Labs: mayor precisión en el modelo de estimación

Esta actualización añade nuevas funciones y mejoras al modelo de aprendizaje profundo de código abierto para la estimación de la profundidad monocular en la visión artificial. MiDaS se ha probado con conjuntos de datos de imágenes grandes y diversos, y es capaz de proporcionar una profundidad relativa en interiores y exteriores, lo que lo convierte en una solución versátil y llena de posibilidades.

Ofrece un buen nivel de rendimiento y presenta un funcionamiento altamente eficiente. Es capaz de estimar la profundidad relativa de cada píxel en una imagen de entrada, y esto lo convierte en una opción muy atractiva y viable en una gran cantidad de aplicaciones y de entornos, incluyendo desde la robótica hasta la realidad aumentada (RA), la realidad virtual (RV) y la visión artificial.

Entre las novedades más importantes de MiDaS 3.1 podemos destacar:

-Nuevos modelos basados en cinco tipos diferentes de transformadores (BEiT, Swin2, Swin, Next-ViT y LeViT). Estos modelos pueden ofrecer una mayor precisión y rendimiento en comparación con los modelos utilizados en versiones anteriores de MiDaS.

-El conjunto de datos de entrenamiento se ha ampliado de 10 a 12 conjuntos de datos, incluyendo la adición de KITTI y NYU Depth V2 utilizando la división BTS. Esta ampliación del conjunto de datos puede mejorar la capacidad de generalización del modelo, permitiéndole actuar con eficacia en una gama más amplia de tareas y entornos.

-BEiTLarge 512, el modelo con mejores resultados, es de media un 28% más preciso que MiDaS 3.0.

-La última versión incluye la posibilidad de realizar estimaciones de profundidad en tiempo real a partir de la imagen de una cámara, lo que podría ser útil en diversas aplicaciones de la visión artificial y robótica, como la navegación y la reconstrucción 3D.

MiDaS 3.1 está disponible en GitHub, donde ha recibido más de 2.600 estrellas (valoraciones positivas) por parte de la comunidad.

« Especial »