Monitor Software

Microsoft se adentra al terreno de los modelos pequeños de lenguaje

Publicación:15-12-2023

TEMA: #Software

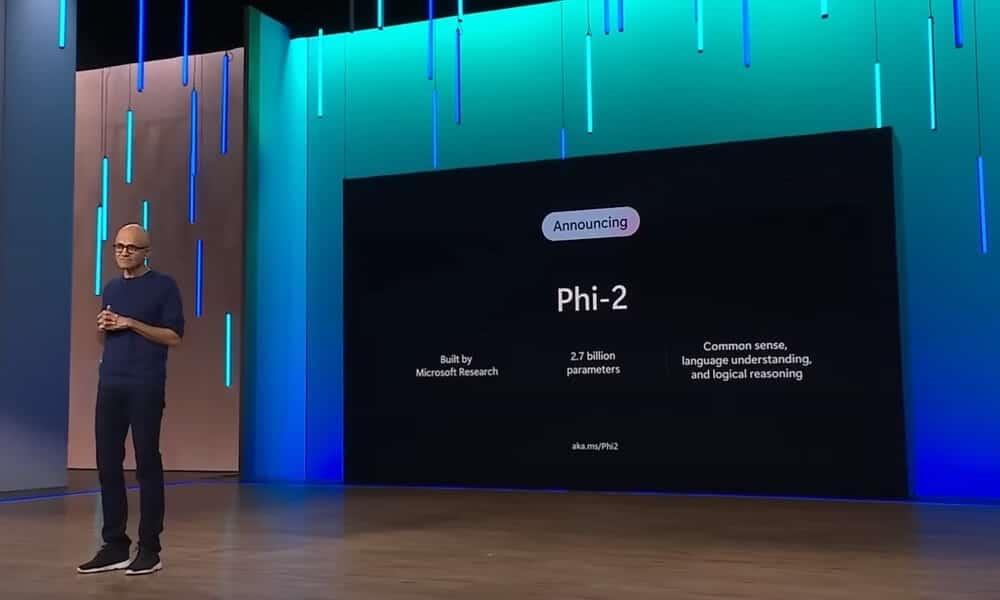

Anunciado en Microsoft Ignite 2023, Phi-2 es un modelo desarrollado para generar código y trabajar con lenguaje natural.

Además de trabajar con modelos grandes de lenguaje, que pueden llegar a contar con cientos de miles de millones de parámetros, Microsoft también está experimentando con otros más pequeños, a los que se conoce, de manera poco original, como modelos pequeños de lenguaje. Son modelos de mucha menor envergadura, pero que pueden llegar a tener un rendimiento bastante parecido a los grandes, aunque a menor escala. Es precisamente lo que están trabajando en Microsoft Research, y que quieren mostrar con el lanzamiento del modelo pequeño de lenguaje Phi-2.

Anunciado en Microsoft Ignite 2023, Phi-2 es un modelo desarrollado para generar código y trabajar con lenguaje natural, que cuenta con 2.700 millones de parámetros, que ha conseguido un rendimiento mejor que algunos modelos de lenguaje más grandes, como Gemini Nano 2, en diversas pruebas.

Desde Microsoft ya han asegurado que, por ahora, Phi-2 se utilizará únicamente en investigación sobre otros modelos de lenguaje. Pero no descargan utilizarlo para el desarrollo de modelos más pequeños y eficientes que puedan tener uso empresarial y puedan competir en rendimiento con otros mucho más grandes.

Phi-2 es el sucesor de Phi-1 un modelo pequeño de lenguaje con 1.300 millones de parámetros lanzado hace apenas tres meses, en septiembre. Este modelo ya consiguió un rendimiento más que aceptable en bancos de pruebas como HumanEval o MBPP, que se encargan de valorar la capacidad de un modelo de desarrollar en Python. El mes pasado, Microsoft presentó Phi-1.5, que sumaba más razonamiento relacionado con el sentido común, y una mejora de la comprensión del lenguaje. Pocos días después llegó Phi-2,

Para el Investigador de Microsoft Mojan Javaheripi, y para el Responsable de investigación de partners de Microsoft Sébastien Bubeck, gracias a su tamaño compacto «Phi-2 es el campo de pruebas perfecto para los investigadores, para tareas como la exploración sobre interpretabilidad mecánica, mejoras de seguridad o experimentar con ajustes para diversas tareas«.

En Microsoft Research aseguran que Phi-2 tiene un rendimiento superior al modelo 7B, de Mistral AI, que tiene 7.000 millones de parámetros. También al Llama 2 de Meta, que tiene 13.000 millones. Los supera en bancos de pruebas estándar, como Big Bench Hard, y en otras pruebas de lenguaje, razonamiento matemático y desarrollo de código. También lo han probado contra Gemini Nano 2, superándole en bancos como el mencionado Big Bench Hard, BooIQ, MBPP y MMLU.

Esto se ha conseguido gracias a que en Microsoft Research han descubierto que los modelos más pequeños pueden tener un rendimiento tan bueno como el de otros de mayor envergadura si se toman decisiones concretas durante su entrenamiento. Una de ellas ha sido utilizar datos con una calidad muy elevada.

Así, según Javaheripi y Bubeck, los datos de entrenamiento utilizados con estos modelos «contiene conjuntos de datos sintéticos creados específicamente para enseñar sentido común en el razonamiento y cultura general al modelo. Entre lo enseñado de esta manera están la ciencia, las actividades cotidianas y la teoría de la mente. También ampliamos nuestro corpus de entrenamiento con datos procedentes de la web y seleccionados cuidadosamente, con base en su calidad y su contenido educacional«.

Otra de las decisiones tomadas en Microsoft Research que ha conseguido que los modelos pequeños tengan un rendimiento tan elevado está relacionada con el escalado. Así, por ejemplo, el equipo de investigación encargado del entrenamiento de estos modelos integró el conocimiento de 1.300 millones de parámetros del modelo Phi-1.5 en el modelo de 2.700 millones de parámetros Phi-2, logrando que «esta transferencia de conocimiento escalado no solo acelere la convergencia del entrenamiento, sino que además muestre un claro impulso en las puntuaciones de Phi-2 en los bancos de prueba«.

« Especial »